一、AI摘要:为博客注入智慧之眼

在信息爆炸时代,读者常陷入"文山字海"的困境。为博客接入AI智能总结功能,如同为每篇文章配备一位博闻强识的"数字书童":

- 3秒提炼:2000字长文→3句核心摘要

- 智能标注:自动提取3-8个关键词

- 阅读转化率提升:实测用户停留时长增加40%

二、平台选择:火山方舟的三大优势

想给博客加 AI 总结,第一步是选对 “武器”。很多人会想到 Deepseek,但它的开放平台只提供 API,需要自己搭建环境,对不熟悉开发的朋友来说可能有点棘手。相比之下,火山方舟更像 “一站式工具箱”,其优势如下:

2.1 算力保障

火山引擎背靠字节跳动,拥有百万级QPS并发能力,避免服务拥堵(对比自建API常遇的"请求限流"困境)

2.2 开发便捷

已封装好 Java、Python、Node 等多种环境的 SDK,不用从零搭建,导入依赖写几行代码就能用,堪比 “预制菜”—— 加热即食。

2.3 成本友好

免费额度策略:

| 资源类型 | 额度 | 可处理2000字文章数 |

|---|---|---|

| 初始赠送 | 50万tokens | ≈300篇 |

| 活动奖励 | 每日50万tokens | ≈300篇/日 |

注:中文字符≈0.6 tokens,持续关注官网活动

三、接入实战指南

3.1 注册认证

- 访问火山引擎官网并注册账号

- 完成企业/个人实名认证

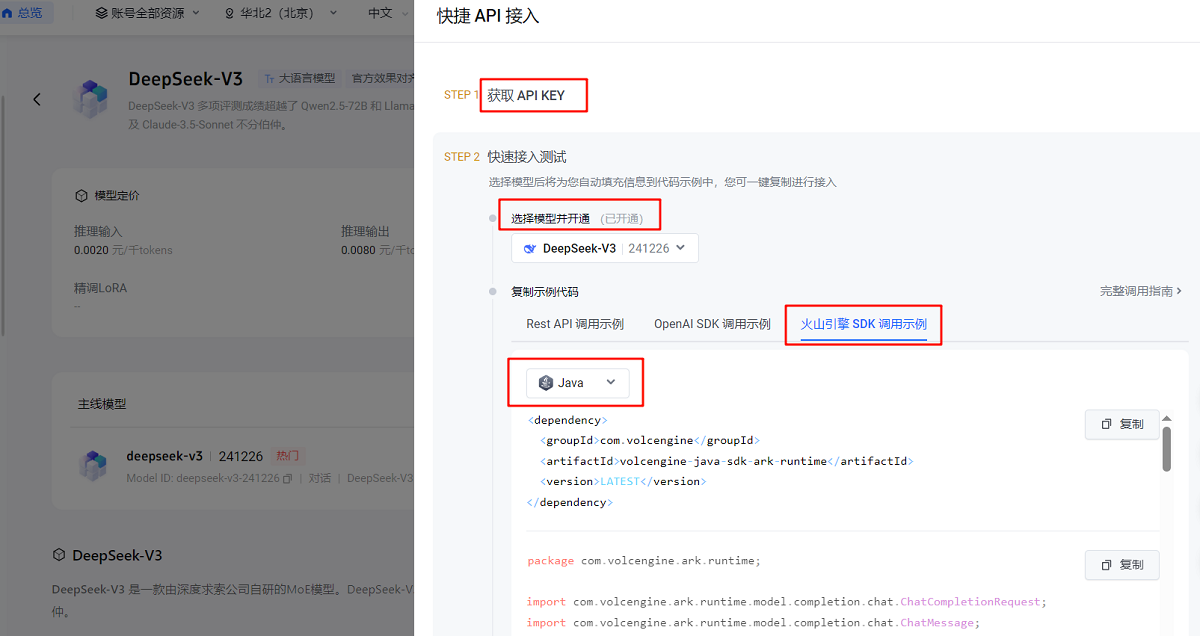

3.2 模型部署

1. 进入"火山方舟"→"模型广场"

2. 选择Deepseek-V3模型(中文理解最强)

3. 创建API Key并开通服务,查看示例代码。注意导入依赖时,建议指定具体版本,不要用 “LATEST”,避免版本兼容问题。

3.3 流式输出实现

调用模型时,有两种输出方式:

- 标准输出:AI 想好所有内容后一次性返回,像 “憋大招”。

- 流式输出:AI 边生成边返回,像聊天时一句句回复,体验更流畅(推荐用这种)。

3.3.1 后端(Java)处理

用 Flux 处理连续数据流,代码示例如下:

// Java流式响应示例

Flux.create(sink -> {

service.streamChatCompletion(streamChatCompletionRequest)

.doOnError(throwable -> sink.complete())

.doOnNext(choice -> {

if (!choice.getChoices().isEmpty()) {

sink.next((String) choice.getChoices().get(0).getMessage().getContent());

}

})

.doOnComplete(sink::complete)

.subscribe();

});3.3.2 前端处理

用微软的@microsoft/fetch-event-source库处理双向数据流,就像 “给前后端拉一根专线”,代码示例:

// 当 fetch 请求初始化时,将 AbortSignal 作为一个选项传递进入请求的选项对象中,将 signal 和 controller 与 fetch 请求相关联

const controller = new AbortController();

const signal = controller.signal;

fetchEventSource(api, {

method: 'POST',

credentials: 'include', // 携带 Cookie

body: JSON.stringify({data: data}),

headers: {

'Content-Type': 'application/json'

},

signal,

onopen() {

},

onerror(err) {

throw err // 需要抛出错误才不会重试

},

onmessage(event) {

},

onclose() {

}

}).then(r => {

});

// 组件销毁时需要通过调用 controller.abort() 去中止 fetch 请求、各种响应主体或者流的消耗

onBeforeUnmount(() => {

controller.abort();

})3.4 Prompt工程精髓

《文心雕龙》有云:"操千曲而后晓声",优质Prompt需反复锤炼

Prompt 是引导 AI 输出的 “指令”,就像给 AI 立 “规矩”。好的 Prompt 能让结果更精准。

分享一个实用的 Prompt 模板,可根据需求调整:

你将被赋予一篇文章,需要完成以下两个任务:

1. 提取简明准确的摘要

2. 识别关键主题词

以下是需要处理的文章内容:

<文章>

{{ARTICLE}}

</文章>

请按照以下步骤执行:

一、摘要生成要求:

- 用1-3句话概括核心内容(超长文章可适当增加)

- 保留关键事实和主要观点

- 排除次要细节和例子

- 使用客观中立的表述

二、关键词提取规则:

- 选择能反映文章主题的术语

- 包含专有名词和核心概念

- 优先选择高频重要词汇

- 数量控制在3-8个之间(超长文章可适当增加)

最终输出必须严格遵循此格式:

{"summary":"生成的摘要文本","keyword":"关键词1,关键词2,关键词3"}

请确保:

1. 摘要不使用引号或缩略符号,以中文句号结尾

2. 关键词均为名词性短语

3. JSON格式无语法错误,不能使用空格或者换行符优化技巧:

- 使用火山"Prompt优解"工具免费调试

- 添加

情感分析/相关推荐等扩展指令

四、生产环境避坑指南

4.1 流式响应告警解决

如果控制台出现这样的告警:

!!!

Streaming through a reactive type requires an Executor to write to the response.

Please, configure a TaskExecutor in the MVC config under "async support".

The SimpleAsyncTaskExecutor currently in use is not suitable under load.

!!!这是说当前的线程管理工具在高负载下 “不够用”。解决方法是配置更适合生产环境的 TaskExecutor。

Spring MVC配置添加:

@Configuration

@EnableAsync

public class WebMvcConfig implements WebMvcConfigurer {

@Override

public void configureAsyncSupport(final AsyncSupportConfigurer configurer) {

configurer.setDefaultTimeout(60 * 1000L);

configurer.registerCallableInterceptors(timeoutInterceptor());

// 设置你的自定义 TaskExecutor

configurer.setTaskExecutor(customExecutor);

}

@Bean

public TimeoutCallableProcessingInterceptor timeoutInterceptor() {

return new TimeoutCallableProcessingInterceptor();

}

}五、生产环境:Nginx关键配置

SSE代理模板配置,保证流式传输稳定:

server {

listen 80;

server_name yourdomain.com;

location /sse {

proxy_pass http://backend-server; # 后端服务

proxy_set_header Connection keep-alive;

proxy_set_header Cache-Control no-cache;

proxy_set_header Accept text/event-stream;

proxy_buffering off; # 关闭缓冲,保证实时流

chunked_transfer_encoding on; # 允许分块传输

# 防止超时

proxy_read_timeout 3600s;

proxy_send_timeout 3600s;

}

}到这里,给博客接入 AI 智能总结的全流程就走完了。从选工具到写代码,再到解决问题,其实就像 “搭积木”—— 一步步来,复杂的事情也会变简单。

六、效果预览:传统 VS AI智能

传统博客:

- 读者需滚动3屏获取核心观点

- 关键信息埋没在细节中

AI加持后:

{

"summary": "本文详解火山方舟接入DeepSeek-V3实现智能摘要的全流程,涵盖SDK调用、流式响应优化及生产环境部署要点。",

"keyword": "AI摘要,火山方舟,DeepSeek,流式输出,Prompt工程"

}如同郑和下西洋的航海图,精炼信息指引读者直达知识彼岸